Un equipo de astrónomos, con ayuda del conjunto de telescopios de ALMA[1] en Chile, ha detectado moléculas de glicolaldehído (una forma simple de azúcar) en el gas que rodea una estrella binaria joven, con masa similar a la del Sol, llamada IRAS 16293-2422. Esta es la primera vez que se ha encontrado glicolaldehído tan cerca de una estrella de este tipo, a distancias comparables a la de Urano del Sol en el sistema solar. Este descubrimiento muestra que algunos de los componentes químicos necesarios para la vida existían en este sistema cuando se estaban formando los planetas.

El glicolaldehído es un tipo de azúcar no muy diferente del que echamos al café. Esta molécula es uno de los ingredientes en la formación de ARN[2], que es uno de los pilares de la vida. Las observaciones de ALMA muestran que las moléculas de azúcar se están moviendo hacia una de las estrellas del sistema, es decir, no sólo están en el lugar adecuado, sino que se dirigen en la dirección apropiada para llegar a algún planeta.

Las nubes de gas y polvo que colapsan para formar nuevas estrellas son extremadamente frías y muchos gases se solidifican en las partículas de polvo donde pueden ligarse entre sí para producir moléculas más complejas. Pero cuando la estrella se ha formado en medio de una nube de gas y polvo que gira sobre sí, comienza a calentar el interior de la nube aproximadamente a temperatura ambiente, lo que provoca la evaporación de las moléculas químicamente complejas y la formación de gases que emiten su radiación característica como ondas de radio que se pueden detectar mediante potentes radiotelescopios como los de ALMA.

IRAS 16293-2422 se encuentra relativamente cerca de la Tierra, a 400 años luz, lo que la hace ideal para que los astrónomos puedan estudiar las moléculas y la química alrededor de estrellas jóvenes. Gracias a la nueva generación de telescopios como ALMA, se puede buscar respuesta a preguntas como la complejidad que pueden alcanzar estas moléculas antes de ser incorporadas a los nuevos planetas. Tal vez esto podría dar algunas pistas de cómo la vida podría surgir en otras partes.

Los telescopios siguen siendo un medio fascinante para descubrir un poco más del universo que nos rodea.

_____

Fuente:

http://www.abc.es/20120830/ciencia/abci-hallan-azucar-alrededor-estrella-201208301406.html

1. ^ Atacama Large Millimeter/submillimeter Array.

2. ^ Como el ADN, con el que está relacionado.

lunes, 31 de diciembre de 2012

lunes, 24 de diciembre de 2012

Seguridad en fronteras con Doppler y sonar

Generalmente, asociamos el ultrasonido a un aparato médico con el que ver el interior del cuerpo y sonar[1] suele ser algo útil principalmente para los submarinos y los murciélagos. Pero ahora los humanos podemos combinar los dos y usarlos al aire libre. Por otro lado, todos conocemos el efecto Doppler, evidente cuando oímos una sirena en un vehículo en movimiento. Pues ahora James Sabatier de la Universidad de Misisipi y su equipo están usando el mismo principio con ultrasonido a 40 kHz para detectar y analizar el movimiento humano.

Con una técnica de sonar similar al radar, ya identificaron en el pasado características clave del andar humano, como las velocidades aisladas de pierna, pie y torso. Asimismo, eran capaces de distinguir seres humanos de otros animales. Ahora están acercando el trabajo más cerca del mundo real.

Un nuevo análisis teórico de los niveles de detección incluye no sólo fallos del equipo, sino también atenuación, ruido ambiental debido al viento y señales dispersadas por el suelo y la vegetación. La conclusión es que pueden detectar a una persona andando a una distancia de 10–17 metros, dependiendo de la elevación del sensor.

Un experimento posterior confirmó el análisis y extrajo propiedades adicionales del paso de un adulto. En particular, un valor por encima de unos 3,6 m del producto de la velocidad máxima de pierna y el tiempo del ciclo de paso, casi exclusivamente indica hombres; aunque valores más pequeños no son específicos de ningún sexo. En general, este tipo de conocimiento podría ser muy útil para vigilar un camino o una carretera cerca de una frontera.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i6/p24_s1

1. ^ O sónar.

Con una técnica de sonar similar al radar, ya identificaron en el pasado características clave del andar humano, como las velocidades aisladas de pierna, pie y torso. Asimismo, eran capaces de distinguir seres humanos de otros animales. Ahora están acercando el trabajo más cerca del mundo real.

Un nuevo análisis teórico de los niveles de detección incluye no sólo fallos del equipo, sino también atenuación, ruido ambiental debido al viento y señales dispersadas por el suelo y la vegetación. La conclusión es que pueden detectar a una persona andando a una distancia de 10–17 metros, dependiendo de la elevación del sensor.

Un experimento posterior confirmó el análisis y extrajo propiedades adicionales del paso de un adulto. En particular, un valor por encima de unos 3,6 m del producto de la velocidad máxima de pierna y el tiempo del ciclo de paso, casi exclusivamente indica hombres; aunque valores más pequeños no son específicos de ningún sexo. En general, este tipo de conocimiento podría ser muy útil para vigilar un camino o una carretera cerca de una frontera.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i6/p24_s1

1. ^ O sónar.

lunes, 17 de diciembre de 2012

Breve historia del átomo

Allá por el siglo V a. C., en Abdera (en el norte de Grecia), surgió el concepto del átomo como consecuencia de la búsqueda de la respuesta a una cuestión existencial, conocido como el desafío eleático: ¿Cómo se puede explicar la pluralidad de las cosas que se encuentran en la naturaleza? La hipótesis atómica fue la respuesta abderitana. Se supone que fue concebida por Leucipo, predecesor del famoso filósofo Demócrito.

Epicuro llevó más allá el concepto de Leucipo de que partículas indivisibles constituyen la base del mundo físico. Aquel identificó ciertos fenómenos empíricos que parecían corroborar la idea de partículas microscópicas que se movían caóticamente en el vacío. La exposición más popular de la hipótesis atómica (que luego amplió Epicuro) se debe a Lucrecio en el siglo I a. C.:

Sin embargo, la hipótesis atómica no fue totalmente aceptada por las generaciones posteriores y el concepto permaneció enterrado durante casi dos milenios. Platón nunca menciona a Demócrito, lo que le llevó a éste a quedar relegado a la oscuridad hasta el Renacimiento tardío.

La hipótesis atómica fue revivida por un buen número de científicos europeos, entre los que están Pierre Gassendi (siglo XVII) y John Dalton (s. XVIII). Los átomos fueron adoptados por la química y se convirtieron en la base de los modelos estadísticos de gases. A finales del s. XIX, con el descubrimiento por Jean Perrin del movimiento browniano en una suspensión coloidal, el concepto del átomo volvió finalmente al mundo de la física.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i5/p40_s1

|

| Epicuro pensando en el movimiento de los átomos. |

Epicuro llevó más allá el concepto de Leucipo de que partículas indivisibles constituyen la base del mundo físico. Aquel identificó ciertos fenómenos empíricos que parecían corroborar la idea de partículas microscópicas que se movían caóticamente en el vacío. La exposición más popular de la hipótesis atómica (que luego amplió Epicuro) se debe a Lucrecio en el siglo I a. C.:

En su curso a través de las profundidades del espacio, los átomos no permanecen quietos, sino que se mueven de forma incesante y variable, chocando unos con otros y rebotando unos más y otros menos... Estos impactos se van acumulando y el movimiento va aumentando desde los átomos y emerge gradualmente al nivel de nuestros sentidos, de modo que los cuerpos que vemos en los rayos de sol están en movimiento debido a choques que permanecen invisibles.

Sin embargo, la hipótesis atómica no fue totalmente aceptada por las generaciones posteriores y el concepto permaneció enterrado durante casi dos milenios. Platón nunca menciona a Demócrito, lo que le llevó a éste a quedar relegado a la oscuridad hasta el Renacimiento tardío.

La hipótesis atómica fue revivida por un buen número de científicos europeos, entre los que están Pierre Gassendi (siglo XVII) y John Dalton (s. XVIII). Los átomos fueron adoptados por la química y se convirtieron en la base de los modelos estadísticos de gases. A finales del s. XIX, con el descubrimiento por Jean Perrin del movimiento browniano en una suspensión coloidal, el concepto del átomo volvió finalmente al mundo de la física.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i5/p40_s1

lunes, 10 de diciembre de 2012

Sensores que pueden "oler"

Para que una máquina pudiera imitar el sentido del olfato de una persona (o mejor, de un perro), tendría que poder determinar la presencia de un cierto vapor químico en pequeñas cantidades, así como qué sustancia química es. Los nanotubos de carbono y otros nanomateriales son capaces de hacer la primera parte. Su pequeño tamaño hace que la presencia de sólo unas pocas moléculas de gas sea suficiente para cambiar sus propiedades eléctricas. Pero, distinguir entre diferentes moléculas es ya algo más difícil.

Ya en el 2005 un grupo de investigadores descubrieron que sensores rodeados de diferentes hebras sencillas de ADN mostraban diferentes respuestas (medidas a través de la conductividad del nanotubo) a las mismas sustancias químicas de los aromas. Los sensores respondían a los olores en segundos, recobraban su conductividad de equilibrio cuando el aroma desaparecía y mantenían una respuesta reproducible durante docenas de ciclos.

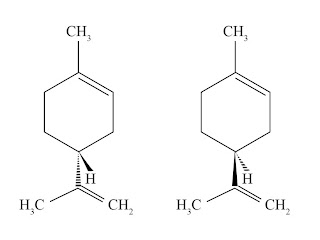

Y ahora tratan de resolver el problema de distinguir entre moléculas muy similares. Con secuencias de ADN adecuadamente escogidas, se pueden crear sensores que distinguen entre moléculas orgánicas que difieren en un simple átomo de carbono e, incluso, entre moléculas que son enantiómeros. Aunque es algo fácil para el sentido olfatorio humano, no lo es tanto para los sensores electrónicos.

La figura muestra un par de enantiómeros: d-limoneno y l-limoneno. Uno huele a limón y el otro huele a pino. Con una secuencia de ADN concreta, la conductividad a través del nanotubo de los sensores aumentaba (hasta un 40%) en presencia de d-limoneno y disminuía igualmente en presencia del l-limoneno. El mismo sensor también podía distinguir, aunque no tan bien, entre los dos enantiómeros de la carvona: uno huele a menta y el otro a comino.

El siguiente paso sería probar los sensores fuera del laboratorio, en diferentes condiciones atmosféricas (humedad, por ejemplo) y en presencia de olores de fondo. Por otro lado, y a pesar del buen resultado de los sensores, aún no se sabe exactamente por qué los sensores con nanotubos rodeados de ADN funcionan. Comprender el proceso permitiría simular las respuestas cuantitativamente.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i6/p22_s1

Ya en el 2005 un grupo de investigadores descubrieron que sensores rodeados de diferentes hebras sencillas de ADN mostraban diferentes respuestas (medidas a través de la conductividad del nanotubo) a las mismas sustancias químicas de los aromas. Los sensores respondían a los olores en segundos, recobraban su conductividad de equilibrio cuando el aroma desaparecía y mantenían una respuesta reproducible durante docenas de ciclos.

Y ahora tratan de resolver el problema de distinguir entre moléculas muy similares. Con secuencias de ADN adecuadamente escogidas, se pueden crear sensores que distinguen entre moléculas orgánicas que difieren en un simple átomo de carbono e, incluso, entre moléculas que son enantiómeros. Aunque es algo fácil para el sentido olfatorio humano, no lo es tanto para los sensores electrónicos.

|

| Los triángulos negros y de rayas representan enlaces químicos que se extienden por encima y por debajo del plano de la página, respectivamente. |

El siguiente paso sería probar los sensores fuera del laboratorio, en diferentes condiciones atmosféricas (humedad, por ejemplo) y en presencia de olores de fondo. Por otro lado, y a pesar del buen resultado de los sensores, aún no se sabe exactamente por qué los sensores con nanotubos rodeados de ADN funcionan. Comprender el proceso permitiría simular las respuestas cuantitativamente.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i6/p22_s1

lunes, 3 de diciembre de 2012

... cromosfera, región de transición

(Este artículo es continuación de El Sol: fotosfera, corona,... Te aconsejo que lo leas primero).

Recordemos que entre la fotosfera y la corona solar existe una zona intermedia, compuesta por la cromosfera y la región de transición. En la cromosfera, los elementos más pequeños que se observan son las espículas, finos chorros de plasma que se encuentran por toda la superficie del Sol y que pueden ascender y caer a velocidades de decenas de kilómetros por segundo. Hay dos tipos y pueden deberse a las ondas acústicas que se propagan hacia fuera o a lo que se conoce como reconexión magnética.

No obstante, no toda la cromosfera está determinada por los campos magnéticos. Y la naturaleza (y temperatura) de esa otra cromosfera no magnética aún no se puede explicar totalmente, ya que parece que no se cumple el principio de conservación de la energía. Las pérdidas de energía son dos veces mayores que las ganancias, lo que impide explicar satisfactoriamente el calentamiento de la cromosfera.

En cuanto a la región de transición, las imágenes revelan también una textura similar a la de la cromosfera, cubriendo el Sol como con una alfombra de pelo largo, especialmente en los polos. También consta de otras prominencias, bucles y material oscuro, reflejo de la complejidad y ubicuidad del campo magnético solar.

Aunque la cromosfera y la región de transición parecerían estar estrechamente ligadas a través del campo magnético que las une, en realidad sus respectivas características no se corresponden. Podría ser que existieran una al lado de la otra como atmósferas interconectadas pero relativamente desacopladas.

A finales de este año 2012 será lanzado el satélite IRIS (Interface Region Imaging Spectrograph), que observará la cromosfera en el ultravioleta y la región de transición en el ultravioleta lejano. Estas observaciones espectroscópicas detalladas pueden darnos más pistas en cuanto a la relación entre estos dos componentes de la atmósfera solar, a la vez fascinantes y problemáticos.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i4/p72_s1

|

| Representación de la variabilidad de la zona entre la fotosfera y la corona solar. |

No obstante, no toda la cromosfera está determinada por los campos magnéticos. Y la naturaleza (y temperatura) de esa otra cromosfera no magnética aún no se puede explicar totalmente, ya que parece que no se cumple el principio de conservación de la energía. Las pérdidas de energía son dos veces mayores que las ganancias, lo que impide explicar satisfactoriamente el calentamiento de la cromosfera.

En cuanto a la región de transición, las imágenes revelan también una textura similar a la de la cromosfera, cubriendo el Sol como con una alfombra de pelo largo, especialmente en los polos. También consta de otras prominencias, bucles y material oscuro, reflejo de la complejidad y ubicuidad del campo magnético solar.

Aunque la cromosfera y la región de transición parecerían estar estrechamente ligadas a través del campo magnético que las une, en realidad sus respectivas características no se corresponden. Podría ser que existieran una al lado de la otra como atmósferas interconectadas pero relativamente desacopladas.

A finales de este año 2012 será lanzado el satélite IRIS (Interface Region Imaging Spectrograph), que observará la cromosfera en el ultravioleta y la región de transición en el ultravioleta lejano. Estas observaciones espectroscópicas detalladas pueden darnos más pistas en cuanto a la relación entre estos dos componentes de la atmósfera solar, a la vez fascinantes y problemáticos.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i4/p72_s1

martes, 27 de noviembre de 2012

El Sol: fotosfera, corona,...

A pesar de la distancia que separa el Sol de la Tierra, el hombre ha

sido capaz a lo largo de su historia de entrever la compleja estructura y

variabilidad del Sol. Por ejemplo, en el 364 a. C., el astrónomo chino

Gan De observó manchas solares, que ahora sabemos que son producto de

los campos magnéticos. La corona solar

es visible desde la Tierra durante los eclipses solares totales. También se

puede ver la cromosfera solar durante un eclipse, justo por encima del limbo;

se trata de grandes protuberancias de color rojo (de ahí su nombre),

fruto de la transición de los átomos de hidrógeno desde los estados

excitados n=3 a n=2.

El Sol es una bola de gas sometida a sus propias fuerzas de gravitación con un núcleo calentado por fusión nuclear. Esta energía se desplaza por radiación y convección desde el núcleo a 1.6 × 107 K hasta la fotosfera a 5800 K. La fotosfera es la superficie visible del Sol, que tiene un grosor de sólo unos 174 km, cantidad que es el resultado del equilibrio hidrostático entre la presión (P) y la gravedad (g☉) a la densidad (ρ) de la superficie (P/ρg☉). La fotosfera es suficientemente densa como para ser opaca, lo que le da un aspecto sólido, y tiene una forma de esfera casi perfecta debido a la gravedad.

El calentamiento y la dinámica de la corona solar aún permanecen un misterio, pero su aspecto puede explicarse de forma sencilla. Por ejemplo, debido a que la presión magnética en la corona (o su densidad de energía) es mucho mayor que la presión de gas y la densidad de energía del potencial gravitatorio, el plasma de la corona traza las líneas del complejo campo magnético solar.

Pero, entre la fotosfera y la corona, existe una zona intermedia, constituida por la cromosfera y la región de transición, en la que las suposiciones usuales no se cumplen. Podremos saber un poco más de esta zona en el próximo artículo.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i4/p72_s1

|

| Representación gráfica de un eclipse solar total. Pueden apreciarse la corona solar y la cromosfera. |

El calentamiento y la dinámica de la corona solar aún permanecen un misterio, pero su aspecto puede explicarse de forma sencilla. Por ejemplo, debido a que la presión magnética en la corona (o su densidad de energía) es mucho mayor que la presión de gas y la densidad de energía del potencial gravitatorio, el plasma de la corona traza las líneas del complejo campo magnético solar.

Pero, entre la fotosfera y la corona, existe una zona intermedia, constituida por la cromosfera y la región de transición, en la que las suposiciones usuales no se cumplen. Podremos saber un poco más de esta zona en el próximo artículo.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i4/p72_s1

miércoles, 21 de noviembre de 2012

Plástico que detecta materiales nucleares

En el Laboratorio Nacional Lawrence Livermore de California (LLNL por sus siglas en inglés) han desarrollado un plástico económico y no peligroso para detectar los patrones neutrónicos característicos de materiales que pueden usarse para crear armas nucleares. Es capaz de distinguir eficientemente neutrones y rayos gamma, por lo que podría usarse en detectores de radiación de mano para las inspecciones internacionales de las plantas de enriquecimiento de uranio y los reactores nucleares. Podría llegar a reemplazar o complementar los detectores de neutrones de los monitores de portal de radiaciones que usan el escaso helio-3.

Los detectores de 3He identifican neutrones térmicos (de baja energía), mientras que este nuevo polímero centellea con los neutrones de alta energía, los que emiten los isótopos fisibles uranio-235 y plutonio-239. Estos neutrones tienen un gran poder de penetración y se pueden detectar a decenas de metros de la fuente. Además, el nivel de fondo de neutrones rápidos es dos órdenes de magnitud más bajo que el de los neutrones térmicos, por lo que sólo es necesario detectar unos pocos para indicar la presencia de materiales susceptibles de ser usados en armas.

Monitores de portal que usen el nuevo material podrían estar listos para ser probados en menos de dos años, a lo que seguirían los detectores de mano. Podría incluso llegar a reemplazar definitivamente los centelladores líquidos que suelen usarse en las tomografías de neutrones y otras aplicaciones científicas.

El equipo está ahora tratando de elaborar un plástico que detecte neutrones térmicos, que son los que identifican los tubos de 3He en la mayoría de monitores de portal actuales.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i3/p28_s1

|

| Examinando el nuevo plástico con un instrumento que produce luz ultravioleta y hace que el material brille con un color azulado. |

Monitores de portal que usen el nuevo material podrían estar listos para ser probados en menos de dos años, a lo que seguirían los detectores de mano. Podría incluso llegar a reemplazar definitivamente los centelladores líquidos que suelen usarse en las tomografías de neutrones y otras aplicaciones científicas.

El equipo está ahora tratando de elaborar un plástico que detecte neutrones térmicos, que son los que identifican los tubos de 3He en la mayoría de monitores de portal actuales.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i3/p28_s1

viernes, 16 de noviembre de 2012

100 años de rayos cósmicos (y VII)

(Este artículo es continuación de 100 años de rayos cósmicos (VI). Te recomiendo que lo leas primero.)

Kenneth Greisen y, de forma independiente, Georgiy Zatsepin y Vadim Kuzmin descubrieron en 1966 que los protones de los rayos cósmicos por encima de un umbral de energía de unos 3 × 1019 eV perderían energía a través de la interacción con fotones poco energéticos de la radiación de fondo de microondas, produciendo piones en el proceso. Por lo tanto predijeron que el espectro de energía mostraría una caída brusca en el umbral; es lo que se conoce como el límite GZK.

Pero existe otra alternativa, ya que hay indicios de que el flujo de radiación cósmica a las energías más altas podría estar dominado por núcleos de hierro en lugar de protones; entonces, la caída podría ser un umbral de fotofragmentación nuclear. También podría ser el reflejo del límite de aceleración de algún tipo de fuentes extragalácticas.

El flujo de partículas de alta energía que llega a la Tierra desde más allá del sistema solar no sólo incluye partículas cargadas, sino también neutras, como los rayos gamma y los neutrinos. Nuevas técnicas de detección diseñadas en principio para la física de partículas se usan ahora también en la investigación de la radiación cósmica. Y a los globos se han unido grandes detectores en satélites.

En el espacio, tenemos detectores como el PAMELA y el Fermi, al que se ha unido recientemente el AMS-02. En el suelo, están el Observatorio Pierre Auger (Argentina), la colaboración internacional Telescope Array (Utah, Estados Unidos), el detector de neutrinos IceCube (Polo Sur) y el telescopio de neutrinos ANTARES (cerca de la costa de Tolón, Francia).

En estas instalaciones (y muchas más), se busca la respuesta a preguntas como: ¿Cuáles son las fuentes extragalácticas de los rayos cósmicos más altamente energéticos? ¿Qué mecanismo alimenta los estallidos de rayos gamma que vemos por el cosmos? ¿Qué nos pueden decir los rayos cósmicos sobre la composición de la materia oscura no bariónica?

Como veis, mucho hemos aprendido y mucho nos queda por aprender. "El camino de la ciencia es infinito".

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i2/p30_s1

Kenneth Greisen y, de forma independiente, Georgiy Zatsepin y Vadim Kuzmin descubrieron en 1966 que los protones de los rayos cósmicos por encima de un umbral de energía de unos 3 × 1019 eV perderían energía a través de la interacción con fotones poco energéticos de la radiación de fondo de microondas, produciendo piones en el proceso. Por lo tanto predijeron que el espectro de energía mostraría una caída brusca en el umbral; es lo que se conoce como el límite GZK.

Pero existe otra alternativa, ya que hay indicios de que el flujo de radiación cósmica a las energías más altas podría estar dominado por núcleos de hierro en lugar de protones; entonces, la caída podría ser un umbral de fotofragmentación nuclear. También podría ser el reflejo del límite de aceleración de algún tipo de fuentes extragalácticas.

El flujo de partículas de alta energía que llega a la Tierra desde más allá del sistema solar no sólo incluye partículas cargadas, sino también neutras, como los rayos gamma y los neutrinos. Nuevas técnicas de detección diseñadas en principio para la física de partículas se usan ahora también en la investigación de la radiación cósmica. Y a los globos se han unido grandes detectores en satélites.

En el espacio, tenemos detectores como el PAMELA y el Fermi, al que se ha unido recientemente el AMS-02. En el suelo, están el Observatorio Pierre Auger (Argentina), la colaboración internacional Telescope Array (Utah, Estados Unidos), el detector de neutrinos IceCube (Polo Sur) y el telescopio de neutrinos ANTARES (cerca de la costa de Tolón, Francia).

En estas instalaciones (y muchas más), se busca la respuesta a preguntas como: ¿Cuáles son las fuentes extragalácticas de los rayos cósmicos más altamente energéticos? ¿Qué mecanismo alimenta los estallidos de rayos gamma que vemos por el cosmos? ¿Qué nos pueden decir los rayos cósmicos sobre la composición de la materia oscura no bariónica?

Como veis, mucho hemos aprendido y mucho nos queda por aprender. "El camino de la ciencia es infinito".

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i2/p30_s1

domingo, 11 de noviembre de 2012

Ultrasonido para diagnosticar cáncer de tiroides

De modo similar a otros órganos, la glándula tiroidea es susceptible de desarrollar nódulos que pueden llegar a resultar malignos. No obstante, gracias a la accesibilidad de la glándula, tales nódulos se detectan fácilmente por medio del ultrasonido. Pero, por otro lado, para determinar si un nódulo es maligno, hay que introducir una aguja en el cuello del paciente y extraer una muestra de células. Tal procedimiento no sólo es costoso[1], sino muchas veces innecesario, pues la mayoría de los nódulos (alrededor de un 70%) son benignos.

Los nódulos malignos son más rígidos que los benignos o que el tejido tiroideo. Por su parte, el ultrasonido, al ser un estímulo mecánico, puede distinguir diferencias en la elasticidad. La cuestión es si, además de detectar los nódulos, puede diagnosticar su malignidad. Según Yongmin Kim y su equipo, sí.

El equipo de Kim ha inventado un algoritmo que optimiza el uso de los datos obtenidos con el ultrasonido. El algoritmo calcula dos cantidades: la velocidad de deformación absoluta píxel por píxel y una medida píxel a píxel del contraste local. A partir de estas, se crea un mapa de contraste de elasticidad. La incorporación del contraste local es especialmente útil a la hora de revelar pequeños nódulos malignos, cuya rigidez característica podría verse enmascarada por la mayor elasticidad del tejido circundante.

El equipo de Kim ha inventado un algoritmo que optimiza el uso de los datos obtenidos con el ultrasonido. El algoritmo calcula dos cantidades: la velocidad de deformación absoluta píxel por píxel y una medida píxel a píxel del contraste local. A partir de estas, se crea un mapa de contraste de elasticidad. La incorporación del contraste local es especialmente útil a la hora de revelar pequeños nódulos malignos, cuya rigidez característica podría verse enmascarada por la mayor elasticidad del tejido circundante.

Para probar este algoritmo, se realizaron pruebas en pacientes cuyos nódulos tiroideos se habían evaluado de forma independiente con otros métodos. Y el resultado fue altamente satisfactorio: se identificaron correctamente 19 nódulos malignos de un total de 20 y 76 nódulos benignos de un total de 103.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i5/p19_s3

1. ^ Unos 1500 $ en los Estados Unidos.

Los nódulos malignos son más rígidos que los benignos o que el tejido tiroideo. Por su parte, el ultrasonido, al ser un estímulo mecánico, puede distinguir diferencias en la elasticidad. La cuestión es si, además de detectar los nódulos, puede diagnosticar su malignidad. Según Yongmin Kim y su equipo, sí.

El equipo de Kim ha inventado un algoritmo que optimiza el uso de los datos obtenidos con el ultrasonido. El algoritmo calcula dos cantidades: la velocidad de deformación absoluta píxel por píxel y una medida píxel a píxel del contraste local. A partir de estas, se crea un mapa de contraste de elasticidad. La incorporación del contraste local es especialmente útil a la hora de revelar pequeños nódulos malignos, cuya rigidez característica podría verse enmascarada por la mayor elasticidad del tejido circundante.

El equipo de Kim ha inventado un algoritmo que optimiza el uso de los datos obtenidos con el ultrasonido. El algoritmo calcula dos cantidades: la velocidad de deformación absoluta píxel por píxel y una medida píxel a píxel del contraste local. A partir de estas, se crea un mapa de contraste de elasticidad. La incorporación del contraste local es especialmente útil a la hora de revelar pequeños nódulos malignos, cuya rigidez característica podría verse enmascarada por la mayor elasticidad del tejido circundante. Para probar este algoritmo, se realizaron pruebas en pacientes cuyos nódulos tiroideos se habían evaluado de forma independiente con otros métodos. Y el resultado fue altamente satisfactorio: se identificaron correctamente 19 nódulos malignos de un total de 20 y 76 nódulos benignos de un total de 103.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i5/p19_s3

1. ^ Unos 1500 $ en los Estados Unidos.

martes, 6 de noviembre de 2012

100 años de rayos cósmicos (VI)

(Este artículo es continuación de 100 años de rayos cósmicos (V). Te recomiendo que lo leas primero.)

Un experimento en globo a 30 km en 1947 reveló que había más que protones en la radiación cósmica. Hoy se sabe que el flujo primario de rayos cósmicos se compone aproximadamente de 87% de protones, 11% de helio y 2% de elementos más pesados. Las abundancias nucleares son similares a las del sistema solar, pero las diferencias dicen más. Por ejemplo, se puede calcular que el flujo de 10Be[1] viaja una media de 5 millones de años hasta llegar a la Tierra.

En 1955, Luis Álvarez descubrió el antiprotón, lo que impulsó una búsqueda de antimateria cósmica. ¿Podrían existir antimundos que nos estuvieran enviando sus antipartículas? La verdad es que, por más que se buscó, no se han encontrado antinúcleos más pesados que el antiprotón. Ya apenas se considera la posibilidad de que existan islas de antimateria.

No obstante, los resultados implican un origen adicional para los positrones, aparte de las colisiones interestelares. El exceso de positrones puede venir de fuentes estelares de alta energía, como los púlsares, o de la destrucción de partículas de materia oscura aún no identificadas.

En 1932 Patrick Blackett y Giuseppe Occhialini iniciaron el estudio del espectro de energía de los rayos cósmicos. Llegaron hasta 20 GeV. En la actualidad, se han observado energías de radiación cósmica primaria hasta unos 1020 eV, pero tales sucesos son extremadamente raros.

Las cascadas de partículas que provocan los rayos cósmicos primarios se pueden detectar en una gran extensión del suelo. Se han registrado separaciones de hasta 300 m. Una sola cascada puede contener más de un millón de partículas secundarias. Al principio, se pensaba que eran cascadas electromagnéticas (de gammas y pares electrón-positrón), pero luego se comprendió que la amplia extensión lateral de las mismas se debía a colisiones nucleares que generaban piones.

Aún nos quedan algunas cuestiones finales. No te pierdas el último artículo de esta serie sobre los rayos cósmicos.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i2/p30_s1

1. ^ El litio, el berilio y el boro son mucho más abundantes en los rayos cósmicos que en el sistema solar.

Un experimento en globo a 30 km en 1947 reveló que había más que protones en la radiación cósmica. Hoy se sabe que el flujo primario de rayos cósmicos se compone aproximadamente de 87% de protones, 11% de helio y 2% de elementos más pesados. Las abundancias nucleares son similares a las del sistema solar, pero las diferencias dicen más. Por ejemplo, se puede calcular que el flujo de 10Be[1] viaja una media de 5 millones de años hasta llegar a la Tierra.

En 1955, Luis Álvarez descubrió el antiprotón, lo que impulsó una búsqueda de antimateria cósmica. ¿Podrían existir antimundos que nos estuvieran enviando sus antipartículas? La verdad es que, por más que se buscó, no se han encontrado antinúcleos más pesados que el antiprotón. Ya apenas se considera la posibilidad de que existan islas de antimateria.

No obstante, los resultados implican un origen adicional para los positrones, aparte de las colisiones interestelares. El exceso de positrones puede venir de fuentes estelares de alta energía, como los púlsares, o de la destrucción de partículas de materia oscura aún no identificadas.

En 1932 Patrick Blackett y Giuseppe Occhialini iniciaron el estudio del espectro de energía de los rayos cósmicos. Llegaron hasta 20 GeV. En la actualidad, se han observado energías de radiación cósmica primaria hasta unos 1020 eV, pero tales sucesos son extremadamente raros.

Las cascadas de partículas que provocan los rayos cósmicos primarios se pueden detectar en una gran extensión del suelo. Se han registrado separaciones de hasta 300 m. Una sola cascada puede contener más de un millón de partículas secundarias. Al principio, se pensaba que eran cascadas electromagnéticas (de gammas y pares electrón-positrón), pero luego se comprendió que la amplia extensión lateral de las mismas se debía a colisiones nucleares que generaban piones.

Aún nos quedan algunas cuestiones finales. No te pierdas el último artículo de esta serie sobre los rayos cósmicos.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i2/p30_s1

1. ^ El litio, el berilio y el boro son mucho más abundantes en los rayos cósmicos que en el sistema solar.

viernes, 2 de noviembre de 2012

100 años de rayos cósmicos (V)

(Este artículo es continuación de 100 años de rayos cósmicos (IV). Te recomiendo que lo leas primero.)

La cámara de niebla de Wilson permitía seguir el rastro de partículas individuales cargadas que se formaban en las cascadas iniciadas por los rayos cósmicos primarios. En 1932, usando una cámara de niebla dentro de un campo magnético, Carl Anderson hizo el primer descubrimiento en la exploración del mundo de las partículas: el positrón, que nos abrió la puerta de la antimateria. Por ello Anderson compartió el premio Nobel con Hess en 1936.

En 1936, con otra cámara de niebla y su estudiante Seth Neddermeyer, Anderson hizo un nuevo descubrimiento. Con una masa intermedia entre el electrón y el protón, ¿podría ser la partícula predicha por Yukawa, mediadora de la interacción fuerte en los núcleos[1]? Parecía ser que no, pues tenía una vida media demasiado larga (unos 2 μs) y la interacción con la materia era demasiado débil. En realidad, se trataba del muón, un leptón cargado parecido al electrón, sólo que 200 veces más pesado.

Hacia el final de la Segunda Guerra Mundial, empezó a usarse la técnica de la emulsión nuclear. Con ella y a 5,5 km en los Andes bolivianos, Cecil Powell y sus colaboradores encontraron por fin en 1947 el mesón de Yukawa: el pión[2]. Así, en 1950 Powell recibió el premio Nobel de física por su desarrollo del método fotográfico para estudiar procesos nucleares y por sus descubrimientos de mesones con este método.

Empezaron, entonces, a sucederse nuevos descubrimientos. Partículas neutras desintegrándose en dos partículas cargadas: el mesón K en dos piones cargados (George Rochester y Clifford Butler, 1947); el hiperón Λ en un protón y un pión negativo. El mesón K+ en tres piones cargados (Powell, 1948). Todas estas partículas se creaban en las cascadas de protones primarios que interaccionaban en la atmósfera.

Tras dos décadas de descubrimientos, la física de partículas empezó a desplazarse a los aceleradores. Así, la investigación de los rayos cósmicos pasó a la astrofísica y la cosmología, comenzando a estudiarse su composición, sus fuentes y los mecanismos de aceleración que los producían.

Pero, aún nos queda saber qué más había en los rayos cósmicos, además de protones. Y en cuanto a la antimateria y los antimundos... No te pierdas el siguiente artículo de la serie.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i2/p30_s1

1. ^ Posteriormente, con el desarrollo de la cromodinámica cuántica, el gluón desplazó al pión como mediador de la interacción fuerte.

2. ^ Con una vida media de unos 10 ns.

La cámara de niebla de Wilson permitía seguir el rastro de partículas individuales cargadas que se formaban en las cascadas iniciadas por los rayos cósmicos primarios. En 1932, usando una cámara de niebla dentro de un campo magnético, Carl Anderson hizo el primer descubrimiento en la exploración del mundo de las partículas: el positrón, que nos abrió la puerta de la antimateria. Por ello Anderson compartió el premio Nobel con Hess en 1936.

|

| Imagen de una cámara de niebla. |

En 1936, con otra cámara de niebla y su estudiante Seth Neddermeyer, Anderson hizo un nuevo descubrimiento. Con una masa intermedia entre el electrón y el protón, ¿podría ser la partícula predicha por Yukawa, mediadora de la interacción fuerte en los núcleos[1]? Parecía ser que no, pues tenía una vida media demasiado larga (unos 2 μs) y la interacción con la materia era demasiado débil. En realidad, se trataba del muón, un leptón cargado parecido al electrón, sólo que 200 veces más pesado.

Hacia el final de la Segunda Guerra Mundial, empezó a usarse la técnica de la emulsión nuclear. Con ella y a 5,5 km en los Andes bolivianos, Cecil Powell y sus colaboradores encontraron por fin en 1947 el mesón de Yukawa: el pión[2]. Así, en 1950 Powell recibió el premio Nobel de física por su desarrollo del método fotográfico para estudiar procesos nucleares y por sus descubrimientos de mesones con este método.

Empezaron, entonces, a sucederse nuevos descubrimientos. Partículas neutras desintegrándose en dos partículas cargadas: el mesón K en dos piones cargados (George Rochester y Clifford Butler, 1947); el hiperón Λ en un protón y un pión negativo. El mesón K+ en tres piones cargados (Powell, 1948). Todas estas partículas se creaban en las cascadas de protones primarios que interaccionaban en la atmósfera.

Tras dos décadas de descubrimientos, la física de partículas empezó a desplazarse a los aceleradores. Así, la investigación de los rayos cósmicos pasó a la astrofísica y la cosmología, comenzando a estudiarse su composición, sus fuentes y los mecanismos de aceleración que los producían.

Pero, aún nos queda saber qué más había en los rayos cósmicos, además de protones. Y en cuanto a la antimateria y los antimundos... No te pierdas el siguiente artículo de la serie.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i2/p30_s1

1. ^ Posteriormente, con el desarrollo de la cromodinámica cuántica, el gluón desplazó al pión como mediador de la interacción fuerte.

2. ^ Con una vida media de unos 10 ns.

domingo, 28 de octubre de 2012

Coches eléctricos de batería: ¿aquí ya?

En un simposio que tuvo lugar en Berkeley a principios de junio sobre la acumulación de energía, se planteó la cuestión de la viabilidad actual de los vehículos totalmente eléctricos. Y la respuesta general fue que, a pesar de sus muchas ventajas potenciales, estos coches no van a poder reemplazar al coche normal de una familia en el próximo futuro. Al menos, en Norteamérica, donde las distancias son tan grandes.

De momento, los vehículos eléctricos de batería (VEB)[1] son una meta a la que nos vamos acercando, pero todavía no estamos lo suficientemente cerca. Utilizar tales coches con lo que algunos llaman una "red verde" eliminaría la dependencia del petróleo importado y reduciría las emisiones de CO2. Sin embargo, la autonomía sigue siendo un gran problema, así como el coste demasiado alto, a pesar de que la electricidad suele ser menos cara que la gasolina para una autonomía dada.

Los investigadores están de acuerdo en que la química de iones de litio usada actualmente en las baterías de los coches eléctricos[2] está alcanzando su madurez, por lo que sólo se pueden esperar pequeñas mejoras en la densidad de energía y el coste, que han de ser mayor y menor, respectivamente, para un uso generalizado de los VEB. Estas baterías son apropiadas para los coches híbridos y medianamente apropiadas para los vehículos híbridos enchufables.

En resumen, parece que hace falta encontrar un nuevo tipo de baterías de alta densidad. De momento, se están investigando dos procesos químicos diferentes como alternativa: litio-oxígeno (litio-aire) y litio-azufre. Teóricamente, ambos ofrecen mucha más densidad de energía de lo que sería posible con las baterías de iones de litio en el máximo de su desarrollo. Sin embargo, las dificultades técnicas a la hora de hacer una batería con una adecuada capacidad de recarga usando cualquiera de estos nuevos procesos químicos son enormes.

Las investigaciones tratan de resolver los grandes problemas relativos al cátodo, el ánodo y el electrolito. Hay estudios que incluyen el uso de nanotubos, nanohilos, nanoesferas y muchos otros nanomateriales. Pero lo cierto es que todavía hace falta mucha investigación para llegar a vislumbrar el camino que tomará la fabricación de baterías para vehículos.

_____

Fuente:

http://www.aps.org/publications/apsnews/201207/electriccars.cfm

1. ^ Vehículos que sólo utilizan la electricidad para moverse.

2. ^ Así como en los ordenadores portátiles y teléfonos móviles, por ejemplo.

De momento, los vehículos eléctricos de batería (VEB)[1] son una meta a la que nos vamos acercando, pero todavía no estamos lo suficientemente cerca. Utilizar tales coches con lo que algunos llaman una "red verde" eliminaría la dependencia del petróleo importado y reduciría las emisiones de CO2. Sin embargo, la autonomía sigue siendo un gran problema, así como el coste demasiado alto, a pesar de que la electricidad suele ser menos cara que la gasolina para una autonomía dada.

Los investigadores están de acuerdo en que la química de iones de litio usada actualmente en las baterías de los coches eléctricos[2] está alcanzando su madurez, por lo que sólo se pueden esperar pequeñas mejoras en la densidad de energía y el coste, que han de ser mayor y menor, respectivamente, para un uso generalizado de los VEB. Estas baterías son apropiadas para los coches híbridos y medianamente apropiadas para los vehículos híbridos enchufables.

En resumen, parece que hace falta encontrar un nuevo tipo de baterías de alta densidad. De momento, se están investigando dos procesos químicos diferentes como alternativa: litio-oxígeno (litio-aire) y litio-azufre. Teóricamente, ambos ofrecen mucha más densidad de energía de lo que sería posible con las baterías de iones de litio en el máximo de su desarrollo. Sin embargo, las dificultades técnicas a la hora de hacer una batería con una adecuada capacidad de recarga usando cualquiera de estos nuevos procesos químicos son enormes.

Las investigaciones tratan de resolver los grandes problemas relativos al cátodo, el ánodo y el electrolito. Hay estudios que incluyen el uso de nanotubos, nanohilos, nanoesferas y muchos otros nanomateriales. Pero lo cierto es que todavía hace falta mucha investigación para llegar a vislumbrar el camino que tomará la fabricación de baterías para vehículos.

_____

Fuente:

http://www.aps.org/publications/apsnews/201207/electriccars.cfm

1. ^ Vehículos que sólo utilizan la electricidad para moverse.

2. ^ Así como en los ordenadores portátiles y teléfonos móviles, por ejemplo.

martes, 23 de octubre de 2012

100 años de rayos cósmicos (IV)

(Este artículo es continuación de 100 años de rayos cósmicos (III). Te recomiendo que lo leas primero.)

La Primera Guerra Mundial supuso un paréntesis en la investigación de los rayos cósmicos. Pero la ciencia seguía avanzando, aunque más lentamente. La mayoría de los físicos aceptaban las conclusiones de Hess y Kolhörster sobre la naturaleza extraterrestre de la radiación de ionización. Entre los que no, destaca el norteamericano Robert Millikan, que era bastante escéptico. Utilizó globos sonda para realizar sus medidas en Texas alcanzando una altura de 15 000 m. Obtuvo una intensidad de radiación no más de un cuarto de lo que Hess y Kolhörster habían obtenido, por lo que concluyó que la radiación penetrante tenía únicamente origen local.

Lo que él no sabía por entonces es que la diferencia se debía a una diferencia geomagnética entre Texas y Europa Central. Posteriormente, cambió de opinión cuando descubrió en unos experimentos en lagos de California a diferentes alturas que dos metros de agua absorbían aproximadamente lo mismo que dos kilómetros de aire. Por lo tanto, los rayos debían venir de arriba. De hecho, viendo la naturaleza electromagnética de esta radiación, Millikan fue el que acuñó el nombre de "rayos cósmicos".

Pero, ¿eran rayos gamma, como muchos todavía creían? En 1927, Jacob Clay descubrió que la intensidad de los rayos cósmicos dependía de la latitud, por lo que al menos parte de la radiación debía ser corpuscular. A Millikan no le convenció este resultado, pero Arthur Compton demostró claramente que existe tal efecto latitudinal (mayor para los rayos cósmicos de menor energía) mediante una serie de expediciones que llevó a cabo en 1932.

En 1928 Hans Geiger y Walther Müller desarrollaron el llamado contador Geiger-Müller, lo que permitía seguir la trayectoria de partículas cargadas individuales. Interponiendo diferentes materiales de distintos grosores entre dos contadores Geiger-Müller, pudieron averiguarse varias propiedades de la radiación en cuestión: Kolhörster y Walther Bothe probaron en 1929 que los rayos cósmicos contenían partículas cargadas mucho más energéticas que los electrones de Compton que producirían los rayos gamma; en 1932 Bruno Rossi descubrió que el flujo de rayos cósmicos contenía no sólo un componente fácilmente absorbido en unos milímetros de plomo, sino también un componente constituido por partículas cargadas con energías de más de 1 GeV.

El campo magnético de la Tierra desviaría las partículas cargadas incidentes, de modo que si fueran negativas, vendrían más desde el este que desde el oeste, y al revés. En 1933, Rossi y otros demostraron que, en efecto, existía un efecto este-oeste que demostraba que la mayoría de los rayos cósmicos eran positivos. Pero, ¿qué eran? ¿Protones, núcleos, los recientemente descubiertos positrones?

La respuesta la hallaron Marcel Schein y sus colaboradores de la Universidad de Chicago en 1940, gracias a un globo con contadores Geiger-Müller que llevaron hasta una altura de 20 km, donde predominan los rayos cósmicos primarios (los que se originan fuera de la atmósfera). A esa altura, las partículas atravesaban láminas de plomo sin generar las cascadas de electrones de baja energía que se esperaría de un electrón o positrón de alta energía. Por lo tanto, los rayos cósmicos eran predominantemente protones.

Pero, ¿qué otras partículas se escondían en los rayos cósmicos? Lo descubrirás en el próximo artículo.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i2/p30_s1

La Primera Guerra Mundial supuso un paréntesis en la investigación de los rayos cósmicos. Pero la ciencia seguía avanzando, aunque más lentamente. La mayoría de los físicos aceptaban las conclusiones de Hess y Kolhörster sobre la naturaleza extraterrestre de la radiación de ionización. Entre los que no, destaca el norteamericano Robert Millikan, que era bastante escéptico. Utilizó globos sonda para realizar sus medidas en Texas alcanzando una altura de 15 000 m. Obtuvo una intensidad de radiación no más de un cuarto de lo que Hess y Kolhörster habían obtenido, por lo que concluyó que la radiación penetrante tenía únicamente origen local.

Lo que él no sabía por entonces es que la diferencia se debía a una diferencia geomagnética entre Texas y Europa Central. Posteriormente, cambió de opinión cuando descubrió en unos experimentos en lagos de California a diferentes alturas que dos metros de agua absorbían aproximadamente lo mismo que dos kilómetros de aire. Por lo tanto, los rayos debían venir de arriba. De hecho, viendo la naturaleza electromagnética de esta radiación, Millikan fue el que acuñó el nombre de "rayos cósmicos".

Pero, ¿eran rayos gamma, como muchos todavía creían? En 1927, Jacob Clay descubrió que la intensidad de los rayos cósmicos dependía de la latitud, por lo que al menos parte de la radiación debía ser corpuscular. A Millikan no le convenció este resultado, pero Arthur Compton demostró claramente que existe tal efecto latitudinal (mayor para los rayos cósmicos de menor energía) mediante una serie de expediciones que llevó a cabo en 1932.

En 1928 Hans Geiger y Walther Müller desarrollaron el llamado contador Geiger-Müller, lo que permitía seguir la trayectoria de partículas cargadas individuales. Interponiendo diferentes materiales de distintos grosores entre dos contadores Geiger-Müller, pudieron averiguarse varias propiedades de la radiación en cuestión: Kolhörster y Walther Bothe probaron en 1929 que los rayos cósmicos contenían partículas cargadas mucho más energéticas que los electrones de Compton que producirían los rayos gamma; en 1932 Bruno Rossi descubrió que el flujo de rayos cósmicos contenía no sólo un componente fácilmente absorbido en unos milímetros de plomo, sino también un componente constituido por partículas cargadas con energías de más de 1 GeV.

El campo magnético de la Tierra desviaría las partículas cargadas incidentes, de modo que si fueran negativas, vendrían más desde el este que desde el oeste, y al revés. En 1933, Rossi y otros demostraron que, en efecto, existía un efecto este-oeste que demostraba que la mayoría de los rayos cósmicos eran positivos. Pero, ¿qué eran? ¿Protones, núcleos, los recientemente descubiertos positrones?

La respuesta la hallaron Marcel Schein y sus colaboradores de la Universidad de Chicago en 1940, gracias a un globo con contadores Geiger-Müller que llevaron hasta una altura de 20 km, donde predominan los rayos cósmicos primarios (los que se originan fuera de la atmósfera). A esa altura, las partículas atravesaban láminas de plomo sin generar las cascadas de electrones de baja energía que se esperaría de un electrón o positrón de alta energía. Por lo tanto, los rayos cósmicos eran predominantemente protones.

Pero, ¿qué otras partículas se escondían en los rayos cósmicos? Lo descubrirás en el próximo artículo.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i2/p30_s1

jueves, 18 de octubre de 2012

100 años de rayos cósmicos (III)

(Este artículo es continuación de 100 años de rayos cósmicos (II). Te recomiendo que lo leas primero.)

Estamos a punto de conocer a Hess, pero antes habría que decir que el camino que llevó al descubrimiento de los rayos cósmicos en 1912 estuvo marcado por muchas contribuciones, entre las que merece la pena destacar la de Domenico Pacini en 1910, que fue el primero en expresar dudas en cuanto a que las observaciones se debían a sustancias radiactivas del suelo y el aire. De hecho, sugirió que la ionización podría deberse a fuentes distintas a las sustancias radiactivas conocidas.

Pero, pasemos ya a Victor Hess. Nació en 1883 en un castillo de la provincia austriaca de Estiria. El castillo era la residencia del príncipe al que su padre servía como guardabosques. Hess obtuvo su doctorado en 1906 en la Universidad de Graz. Intrigado por los resultados de Wulf, intentó mejorar los datos de la absorción de la radiactividad en el aire. Pero sus resultados sólo confirmaron los de Wulf y Gockel.

Hess modificó el electroscopio de Wulf para que aguantara las condiciones de las grandes alturas e hizo hasta diez vuelos en globo desde 1911 a 1913. Solía llevar tres electroscopios a bordo, uno con una ventana más fina para medir la radiación beta. El 7 de agosto de 1912 observó un aumento muy significativo de la ionización a gran altura, lo que le llevó a afirmar que sus resultados parecían explicarse con facilidad si suponemos que una radiación de muy alto poder de penetración entra en la atmósfera desde arriba y aún puede producir una parte de la ionización observada en los electroscopios cerrados en las zonas más bajas. Por este descubrimiento, Hess recibió el premio Nobel de Física en 1936.

Werner Kolhörster confirmó los resultados de Hess en 1914. Además, determinó que la longitud de absorción de la radiación era de unos 1300 m, un orden de magnitud mayor que el valor medido para la radiación gamma de las fuentes radiactivas. La intensidad de la radiación era bastante constante, sin variaciones dependientes del tiempo o de la noche y el día.

¿Cuál podría ser el origen de esta radiación? Lo puedes averiguar en el próximo artículo.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i2/p30_s1

Estamos a punto de conocer a Hess, pero antes habría que decir que el camino que llevó al descubrimiento de los rayos cósmicos en 1912 estuvo marcado por muchas contribuciones, entre las que merece la pena destacar la de Domenico Pacini en 1910, que fue el primero en expresar dudas en cuanto a que las observaciones se debían a sustancias radiactivas del suelo y el aire. De hecho, sugirió que la ionización podría deberse a fuentes distintas a las sustancias radiactivas conocidas.

|

| Victor Hess |

Hess modificó el electroscopio de Wulf para que aguantara las condiciones de las grandes alturas e hizo hasta diez vuelos en globo desde 1911 a 1913. Solía llevar tres electroscopios a bordo, uno con una ventana más fina para medir la radiación beta. El 7 de agosto de 1912 observó un aumento muy significativo de la ionización a gran altura, lo que le llevó a afirmar que sus resultados parecían explicarse con facilidad si suponemos que una radiación de muy alto poder de penetración entra en la atmósfera desde arriba y aún puede producir una parte de la ionización observada en los electroscopios cerrados en las zonas más bajas. Por este descubrimiento, Hess recibió el premio Nobel de Física en 1936.

Werner Kolhörster confirmó los resultados de Hess en 1914. Además, determinó que la longitud de absorción de la radiación era de unos 1300 m, un orden de magnitud mayor que el valor medido para la radiación gamma de las fuentes radiactivas. La intensidad de la radiación era bastante constante, sin variaciones dependientes del tiempo o de la noche y el día.

¿Cuál podría ser el origen de esta radiación? Lo puedes averiguar en el próximo artículo.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i2/p30_s1

sábado, 13 de octubre de 2012

La mecánica del traumatismo craneoencefálico

Los traumatismos craneoencefálicos son una importante causa de muerte e invalidez. Suelen ser provocados por impactos con elementos contundentes y por aceleraciones angulares rápidas, como sucede en los accidentes de tráfico o deportivos, en las caídas u otros incidentes. Desde un punto de vista mecánico, tales lesiones ocurren cuando la carga mecánica local excede ciertos niveles de tolerancia del tejido cerebral. Ahora bien, la determinación de tales niveles no es tan sencilla. No sólo hacen falta modelos realistas de la respuesta dinámica del cerebro, sino también determinaciones precisas de las propiedades materiales del tejido bajo condiciones de carga reales.

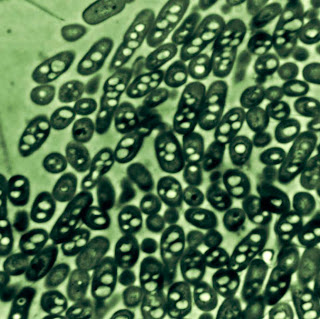

Las cosas se complican más debido a la compleja geometría del cerebro y su significativa falta de homogeneidad, tanto a niveles macroscópicos como microscópicos. En concreto, la sustancia gris del cerebro, formada principalmente por somas neuronales, es fundamentalmente isótropa. En cambio, la sustancia blanca, que consiste en grupos de axones (o fibras nerviosas) que llevan las señales a otras neuronas, pueden tener orientación, como se aprecia en la figura[1]. En muchos tipos de accidentes, los axones son especialmente vulnerables, principalmente en el límite entre la sustancia gris y la blanca.

Badar Rashid, Michel Destrade y Michael Gilchrist, de la Universidad Colegio de Dublín y la Universidad Nacional de Irlanda, Galway, han realizado recientemente unos estudios en tejido cerebral porcino, ya que mecánicamente es similar al tejido cerebral humano. Llevaron a cabo medidas y simulaciones detalladas de tensión dinámica bajo condiciones de impacto: tensiones compresivas de hasta un 50% y velocidades de tensión de hasta 9% por milisegundo, lo que corresponde con velocidades de 450 mm/s. Sus resultados sobre especímenes de sustancia gris y blanca mezcladas demuestran que los modelos lineales, llamados hiperviscoelásticos, describen bien los impactos de la vida real. De ellos obtuvieron varios parámetros mecánicos necesarios para que tales modelos sean fiables biológicamente.

Les deseamos los mejor y ya os informaremos cuando hagan públicos sus avances.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i7/p72_s1

1.^ Se trata de una representación artística de una micrografía electrónica del cerebro. El tamaño real que representa es de unos 20 μm por 30 μm.

Las cosas se complican más debido a la compleja geometría del cerebro y su significativa falta de homogeneidad, tanto a niveles macroscópicos como microscópicos. En concreto, la sustancia gris del cerebro, formada principalmente por somas neuronales, es fundamentalmente isótropa. En cambio, la sustancia blanca, que consiste en grupos de axones (o fibras nerviosas) que llevan las señales a otras neuronas, pueden tener orientación, como se aprecia en la figura[1]. En muchos tipos de accidentes, los axones son especialmente vulnerables, principalmente en el límite entre la sustancia gris y la blanca.

|

| Representación artística de la sustancia blanca del cerebro. |

Les deseamos los mejor y ya os informaremos cuando hagan públicos sus avances.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i7/p72_s1

1.^ Se trata de una representación artística de una micrografía electrónica del cerebro. El tamaño real que representa es de unos 20 μm por 30 μm.

lunes, 8 de octubre de 2012

100 años de rayos cósmicos (II)

(Este artículo es continuación de 100 años de rayos cósmicos (I). Te recomiendo que lo leas primero.)

Pero, ¿por qué Hess y otros como él montaban en globos para hacer su investigación a grandes alturas? Ya lo veremos, pero todo empezó en 1785, cuando Charles-Augustin de Coulomb descubrió que una esfera metálica cargada, en contacto con el aire, pierde su carga gradualmente. Un siglo más tarde, William Crookes observó que la velocidad con la que un electroscopio pierde su carga disminuye al aumentar la presión.

A principios del siglo XX, una serie de descubrimientos fueron marcando el camino que se había iniciado: Joseph J. Thomson descubrió el electrón, Wilhelm Röntgen descubrió los rayos X y Henri Becquerel descubrió la radiactividad. La radiación de los rayos X y las sales de uranio de Becquerel tenían propiedades de penetración similares y ambos podían ionizar el aire. Poco después, Marie y Pierre Curie hallaron nuevos elementos radiactivos.

De este modo, se fue ampliando el estudio de la conductividad eléctrica del aire y la ionización atmosférica. Muchos físicos de Europa y Norteamérica contribuyeron a esta investigación, llegando a la conclusión de que la ionización debía de ser causada por rayos X o rayos gamma procedentes del exterior del recipiente que encerraba el electroscopio. Charles T.R. Wilson incluso sugirió que la fuente de la radiación podría ser extraterrestre.

Ernest Rutherford y otros descubrieron en 1903 que la ionización se reducía cuando se cubría el electroscopio con un metal libre de radiactividad. De ello se dedujo que al menos parte de la ionización debería ser debida a algún tipo de radiación penetrante; pronto se pensó en el material radiactivo de la corteza terrestre como la fuente de tal radiación. Y si esto era así, entonces la radiación debería disminuir al aumentar la altura sobre el suelo.

Para confirmar esta suposición, Theodor Wulf, científico alemán y sacerdote jesuita, mejoró la fiabilidad y la sensibilidad del electroscopio en 1909. Se subió a la Torre Eiffel y midió la velocidad de ionización atmosférica; sin embargo, aunque era menor que en el suelo, era mayor que el valor esperado. Por lo tanto, o la longitud de absorción de los rayos gamma en el aire era mayor de lo que se creía o debía haber otra fuente de radiactividad atmosférica. Un resultado similar obtuvo el físico suizo Albert Gockel entre 1909 y 1911 en sus vuelos en globo. Él, sin embargo, atribuyó el resultado al efecto de rayos gamma procedentes de sustancias radiactivas en la atmósfera.

Pero, ¿de dónde procede esta radiación? ¿Y cuándo aparece Victor Hess? ¿Hubo alguien antes que él con una conclusión similar a la suya? Todo esto y más, en la próxima parte de esta serie sobre los rayos cósmicos.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i2/p30_s1

Pero, ¿por qué Hess y otros como él montaban en globos para hacer su investigación a grandes alturas? Ya lo veremos, pero todo empezó en 1785, cuando Charles-Augustin de Coulomb descubrió que una esfera metálica cargada, en contacto con el aire, pierde su carga gradualmente. Un siglo más tarde, William Crookes observó que la velocidad con la que un electroscopio pierde su carga disminuye al aumentar la presión.

A principios del siglo XX, una serie de descubrimientos fueron marcando el camino que se había iniciado: Joseph J. Thomson descubrió el electrón, Wilhelm Röntgen descubrió los rayos X y Henri Becquerel descubrió la radiactividad. La radiación de los rayos X y las sales de uranio de Becquerel tenían propiedades de penetración similares y ambos podían ionizar el aire. Poco después, Marie y Pierre Curie hallaron nuevos elementos radiactivos.

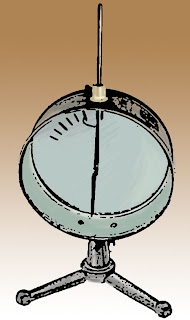

De este modo, se fue ampliando el estudio de la conductividad eléctrica del aire y la ionización atmosférica. Muchos físicos de Europa y Norteamérica contribuyeron a esta investigación, llegando a la conclusión de que la ionización debía de ser causada por rayos X o rayos gamma procedentes del exterior del recipiente que encerraba el electroscopio. Charles T.R. Wilson incluso sugirió que la fuente de la radiación podría ser extraterrestre.

|

| Electroscopio de Wulf. |

Para confirmar esta suposición, Theodor Wulf, científico alemán y sacerdote jesuita, mejoró la fiabilidad y la sensibilidad del electroscopio en 1909. Se subió a la Torre Eiffel y midió la velocidad de ionización atmosférica; sin embargo, aunque era menor que en el suelo, era mayor que el valor esperado. Por lo tanto, o la longitud de absorción de los rayos gamma en el aire era mayor de lo que se creía o debía haber otra fuente de radiactividad atmosférica. Un resultado similar obtuvo el físico suizo Albert Gockel entre 1909 y 1911 en sus vuelos en globo. Él, sin embargo, atribuyó el resultado al efecto de rayos gamma procedentes de sustancias radiactivas en la atmósfera.

Pero, ¿de dónde procede esta radiación? ¿Y cuándo aparece Victor Hess? ¿Hubo alguien antes que él con una conclusión similar a la suya? Todo esto y más, en la próxima parte de esta serie sobre los rayos cósmicos.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i2/p30_s1

miércoles, 3 de octubre de 2012

100 años de rayos cósmicos (I)

Hace ya un siglo que se descubrieron los rayos cósmicos y la historia de su descubrimiento e investigación es toda una hazaña que merece que le dediquemos unos cuantos artículos.

El 7 de agosto de 1912, el físico austriaco Victor Franz Hess hizo su séptimo viaje en globo de ese año desde la ciudad bohemia de Aussig. El trayecto le llevaría, por primera vez, a una altitud de 5000 metros. Para su sorpresa, se encontró con que sus electroscopios mostraban que la ionización de la atmósfera no disminuía al aumentar la altitud. En cambio, a una altura de 4500 m, midió una ionización tres veces mayor que en el suelo. Su hallazgo suele considerarse el descubrimiento de los rayos cósmicos.

No te pierdas el siguiente capítulo, donde echaremos un vistazo al comienzo de esta aventura.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i2/p30_s1

La historia de la investigación de la radiación cósmica es una historia de aventura científica. Durante casi un siglo, los investigadores de la radiación cósmica han escalado montañas, han montado en globos de aire caliente y han viajado a los lugares más distantes de la tierra en su búsqueda por comprender estas veloces partículas provenientes del espacio. (De la página web del Observatorio Pierre Auger sobre los rayos cósmicos).Veinte años después de que la desconcertante ionización atmosférica llevara al descubrimiento de los rayos cósmicos, su investigación abrió el camino a la física de partículas. Ahora nos proporcionan una ventana abierta a la astrofísica extragaláctica.

El 7 de agosto de 1912, el físico austriaco Victor Franz Hess hizo su séptimo viaje en globo de ese año desde la ciudad bohemia de Aussig. El trayecto le llevaría, por primera vez, a una altitud de 5000 metros. Para su sorpresa, se encontró con que sus electroscopios mostraban que la ionización de la atmósfera no disminuía al aumentar la altitud. En cambio, a una altura de 4500 m, midió una ionización tres veces mayor que en el suelo. Su hallazgo suele considerarse el descubrimiento de los rayos cósmicos.

No te pierdas el siguiente capítulo, donde echaremos un vistazo al comienzo de esta aventura.

_____

Fuente:

http://www.physicstoday.org/resource/1/phtoad/v65/i2/p30_s1

miércoles, 26 de septiembre de 2012

Una bacteria que podría convertir CO2 en combustible (y II)

(Este artículo es continuación de Una bacteria que podría convertir CO2 en combustible (I). Te recomiendo que lo leas primero).

De momento, lo que ha logrado el equipo del MIT es que el microbio convierta carbono en isobutanol de forma continua. Ahora los investigadores están centrando sus esfuerzos en optimizar el sistema para aumentar el ritmo de producción, así como en diseñar biorreactores para ampliar el proceso a niveles industriales.

A diferencia de algunos sistemas de ingeniería biológica en los que los microbios producen un producto químico deseado dentro de sus cuerpos y tienen que ser destruidos para obtener el producto, la Ralstonia eutropha expulsa el isobutanol en el fluido que la rodea, de donde se puede extraer sin parar el proceso de producción.

Otros grupos de investigación buscan cómo producir isobutanol de diversas formas, incluyendo a través de otros organismos modificados genéticamente. Al menos dos compañías se están preparando para producirlo como combustible, aditivo para combustible o materia prima para la producción de sustancias químicas. A diferencia de algunos biocombustibles propuestos, el isobutanol se puede usar en los motores actuales con apenas modificación (o ninguna) y ya se ha usado en algunos coches de carreras.

En resumen, este método tiene varias ventajas potenciales frente a la producción de etanol a partir de maíz. Los sistemas bacterianos se pueden ampliar a otras escalas fácilmente; de este modo, en teoría, se podrían producir grandes cantidades de biocombustible en un entorno de tipo industrial. Además, este sistema en concreto tiene el potencial de obtener el carbono a partir de productos de desecho o de dióxido de carbono, por lo que no compite con el suministro de alimentos.

Increíble, ¿verdad?

_____

Fuente:

http://web.mit.edu/newsoffice/2012/genetically-modified-organism-can-turn-carbon-dioxide-into-fuel-0821.html

De momento, lo que ha logrado el equipo del MIT es que el microbio convierta carbono en isobutanol de forma continua. Ahora los investigadores están centrando sus esfuerzos en optimizar el sistema para aumentar el ritmo de producción, así como en diseñar biorreactores para ampliar el proceso a niveles industriales.

A diferencia de algunos sistemas de ingeniería biológica en los que los microbios producen un producto químico deseado dentro de sus cuerpos y tienen que ser destruidos para obtener el producto, la Ralstonia eutropha expulsa el isobutanol en el fluido que la rodea, de donde se puede extraer sin parar el proceso de producción.

Otros grupos de investigación buscan cómo producir isobutanol de diversas formas, incluyendo a través de otros organismos modificados genéticamente. Al menos dos compañías se están preparando para producirlo como combustible, aditivo para combustible o materia prima para la producción de sustancias químicas. A diferencia de algunos biocombustibles propuestos, el isobutanol se puede usar en los motores actuales con apenas modificación (o ninguna) y ya se ha usado en algunos coches de carreras.

En resumen, este método tiene varias ventajas potenciales frente a la producción de etanol a partir de maíz. Los sistemas bacterianos se pueden ampliar a otras escalas fácilmente; de este modo, en teoría, se podrían producir grandes cantidades de biocombustible en un entorno de tipo industrial. Además, este sistema en concreto tiene el potencial de obtener el carbono a partir de productos de desecho o de dióxido de carbono, por lo que no compite con el suministro de alimentos.

Increíble, ¿verdad?

_____

Fuente:

http://web.mit.edu/newsoffice/2012/genetically-modified-organism-can-turn-carbon-dioxide-into-fuel-0821.html

domingo, 23 de septiembre de 2012

Una bacteria que podría convertir CO2 en combustible (I)

Un organismo modificado genéticamente podría llegar a convertir dióxido de carbono o productos de desecho en un combustible utilizado por el sector de transporte compatible con la gasolina. El organismo en sí es una bacteria terrestre llamada Ralstonia eutropha que tiene una característica peculiar: cuando se encuentra bajo presión, deja de crecer y emplea toda su energía en crear compuestos complejos de carbono. Y haciendo algunos ajustes genéticos, unos científicos del Instituto Tecnológico de Massachussets (MIT, por sus siglas en inglés) han logrado que la bacteria cree isobutanol, un tipo de alcohol que puede mezclarse con la gasolina o usarse directamente como combustible.

El equipo del MIT, liderado por el biólogo Christopher Brigham, está ahora intentando hacer que el organismo use una corriente de dióxido de carbono como fuente de carbono, de forma que podría usarse para crear combustible a partir de emisiones de CO2.

En el estado natural del microbio, cuando su fuente de nutrientes esenciales (nitrato o fosfato) se ve limitada, empieza a guardar comida para después. Toma cualquier carbono que esté disponible y lo almacena en forma de polímero, que es similar en sus propiedades a muchos plásticos derivados del petróleo. Así, eliminando unos genes, insertando un gen de otro organismo y ajustando la expresión de otros genes, Brigham y su equipo lograron redirigir al microbio para que produjera combustible en lugar de plástico.

Aunque el equipo se está centrando en lograr que el microbio use CO2 como fuente de carbono, con unas modificaciones ligeramente diferentes el mismo microbio podría en principio convertir en combustible casi cualquier fuente de carbono, incluyendo desechos agrícolas o municipales. En el laboratorio, los microbios han estado usando fructosa, un azúcar, como fuente de carbono.

Y aunque no acaba aquí la cosa, me temo que tendrás que leer el próximo artículo para conocer el resto.

_____

Fuente:

http://web.mit.edu/newsoffice/2012/genetically-modified-organism-can-turn-carbon-dioxide-into-fuel-0821.html

El equipo del MIT, liderado por el biólogo Christopher Brigham, está ahora intentando hacer que el organismo use una corriente de dióxido de carbono como fuente de carbono, de forma que podría usarse para crear combustible a partir de emisiones de CO2.

En el estado natural del microbio, cuando su fuente de nutrientes esenciales (nitrato o fosfato) se ve limitada, empieza a guardar comida para después. Toma cualquier carbono que esté disponible y lo almacena en forma de polímero, que es similar en sus propiedades a muchos plásticos derivados del petróleo. Así, eliminando unos genes, insertando un gen de otro organismo y ajustando la expresión de otros genes, Brigham y su equipo lograron redirigir al microbio para que produjera combustible en lugar de plástico.

Aunque el equipo se está centrando en lograr que el microbio use CO2 como fuente de carbono, con unas modificaciones ligeramente diferentes el mismo microbio podría en principio convertir en combustible casi cualquier fuente de carbono, incluyendo desechos agrícolas o municipales. En el laboratorio, los microbios han estado usando fructosa, un azúcar, como fuente de carbono.

Y aunque no acaba aquí la cosa, me temo que tendrás que leer el próximo artículo para conocer el resto.

_____

Fuente:

http://web.mit.edu/newsoffice/2012/genetically-modified-organism-can-turn-carbon-dioxide-into-fuel-0821.html

lunes, 17 de septiembre de 2012

Detectores muónicos contra el contrabando de materiales fisibles

Buscar armas nucleares ocultas puede ser una tarea ardua. Sin embargo, se está mejorando una técnica que usa la radiación natural de rayos cósmicos y nos permite así "ver" a través de objetos sólidos y encontrar cualquier material fisible que se encuentre escondido.

Para buscar materiales nucleares, se coloca un contenedor

entre dos conjuntos de grandes placas con detectores GEM. Dos placas por encima

del contenedor graban los caminos de los muones entrantes, y dos placas por

debajo siguen los caminos de los muones que salen. Si no hay materiales densos

en el contenedor, las dos partes del camino del muon deberían alinearse.

Incluso el hierro apenas desviaría los muones. Sin embargo, si hay una gran

cantidad de material denso (como plutonio, uranio o blindaje de plomo), los caminos se desviarían notablemente. De este modo, si ponen más protección de plomo para evitar

la detección del material nuclear, lo que se detectaría es ese mayor blindaje.

Para buscar materiales nucleares, se coloca un contenedor

entre dos conjuntos de grandes placas con detectores GEM. Dos placas por encima

del contenedor graban los caminos de los muones entrantes, y dos placas por

debajo siguen los caminos de los muones que salen. Si no hay materiales densos

en el contenedor, las dos partes del camino del muon deberían alinearse.

Incluso el hierro apenas desviaría los muones. Sin embargo, si hay una gran

cantidad de material denso (como plutonio, uranio o blindaje de plomo), los caminos se desviarían notablemente. De este modo, si ponen más protección de plomo para evitar

la detección del material nuclear, lo que se detectaría es ese mayor blindaje.

Cuando un rayo cósmico choca con un núcleo de la atmósfera,

produce una lluvia de partículas subatómicas, incluyendo piones y kaones que se

desintegran en muones de larga vida.

Estos muones viajan a grandes velocidades por la atmósfera y atraviesan objetos

sólidos. Pues bien, ahora se puede usar este fenómeno natural para buscar

materiales nucleares escondidos y cualquier recubrimiento que trate de

ocultarlos.

En promedio, un muon choca con cada centímetro cuadrado de

la Tierra cada minuto. Los detectores de

tipo multiplicador gaseoso de electrones (GEM por sus siglas en inglés) pueden

detectar su localización. Y cuando se colocan varios uno encima del otro,

pueden seguir el camino de

estas veloces partículas. Cuanto más denso es el material que atraviesa el

muon, más se desvía su camino. El uranio y el plutonio son dos de los elementos

más densos de la tabla periódica, por lo que los detectores se usan para buscar

sitios donde los caminos de los muones se desvían más. Por otra parte, como no se necesita una fuente de radiación artificial, no

se expone al objeto a una radiación mayor que la que ya experimentaría de por

sí.

Para buscar materiales nucleares, se coloca un contenedor

entre dos conjuntos de grandes placas con detectores GEM. Dos placas por encima

del contenedor graban los caminos de los muones entrantes, y dos placas por

debajo siguen los caminos de los muones que salen. Si no hay materiales densos

en el contenedor, las dos partes del camino del muon deberían alinearse.

Incluso el hierro apenas desviaría los muones. Sin embargo, si hay una gran

cantidad de material denso (como plutonio, uranio o blindaje de plomo), los caminos se desviarían notablemente. De este modo, si ponen más protección de plomo para evitar

la detección del material nuclear, lo que se detectaría es ese mayor blindaje.

Para buscar materiales nucleares, se coloca un contenedor

entre dos conjuntos de grandes placas con detectores GEM. Dos placas por encima

del contenedor graban los caminos de los muones entrantes, y dos placas por

debajo siguen los caminos de los muones que salen. Si no hay materiales densos

en el contenedor, las dos partes del camino del muon deberían alinearse.

Incluso el hierro apenas desviaría los muones. Sin embargo, si hay una gran