Seguimos echando un vistazo a diversas maneras de combatir la degradación del medio ambiente mediante aplicaciones de la física.

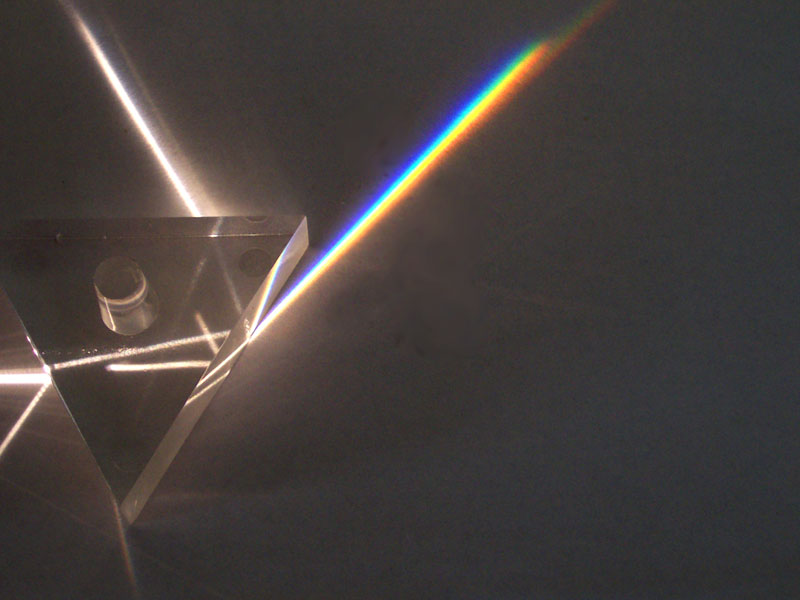

Ahora se trata de mejorar la conversión de la luz solar en electricidad. Howard Branz se centra en la división espectral, que posiblemente sea el siguiente gran paso para utilizar la energía solar. Existe un grupo en el Instituto de Tecnología de California (Caltech) que utiliza espejos especiales para dividir la luz blanca en sus longitudes de onda constituyentes, que posteriormente hacen confluir en aparatos fotovoltaicos optimizados para rangos específicos de longitudes de onda. Esta técnica podría aumentar la eficiencia de una célula solar de aproximadamente un 5% a un 50%.

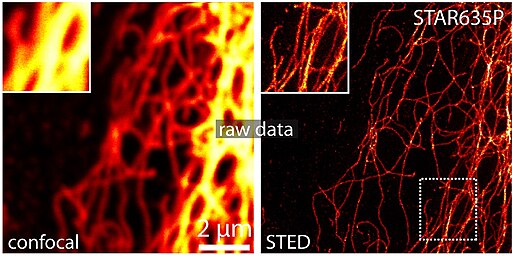

|

| División de la luz en el espectro visible. [Foto de Fir0002 (talk) (Uploads) (Fir0002 (talk) (Uploads)) [GFDL, CC-BY-SA-3.0, GFDL or CC-BY-SA-3.0], via Wikimedia Commons] |

Existen otros científicos para los que generar electricidad sin producir dióxido de carbono no es suficiente. Preocupado por la cantidad en aumento de gases de invernadero en la atmósfera, Klaus Lackner está desarrollando nuevos materiales de membrana para eliminar dióxido de carbono del aire. Está trabajando en un aparato que, teóricamente, puede absorber dióxido de carbono mil veces más rápido que un árbol.

El año pasado Lackner fundó el Centro de Emisiones Negativas de Carbono en la Universidad Estatal de Arizona, donde él y su equipo han estado trabajando en la creación de diferentes prototipos para eliminar dióxido de carbono de forma eficiente y económica.

Su equipo ha estado experimentando con diferentes diseños de aparatos y resinas de intercambio aniónico que se enlazan con el dióxido de carbono. Las resinas se usan actualmente en la purificación del agua, pero son ideales para la captura de CO2 porque el dióxido de carbono se puede extraer en agua ordinaria para su almacenamiento y la resina se puede reutilizar.

El prototipo que ha estado desarrollando usa una estructura de entramado semejante a la tela metálica hexagonal, para maximizar la superficie. Espera tener pronto un prototipo funcional en el techo de su edificio. Este tipo de aparato tiene varias ventajas: es totalmente pasivo, está formado por unidades más pequeñas que se pueden producir en masa y el material básico es muy, muy barato.

Sin embargo, el reto de limpiar la atmósfera del exceso de carbono es tremendo. Lackner estima que se necesitarían cien millones de sus aparatos tamaño contenedor para contrarrestar completamente la cantidad de dióxido de carbono que se ha ido acumulando durante los últimos 200 años.

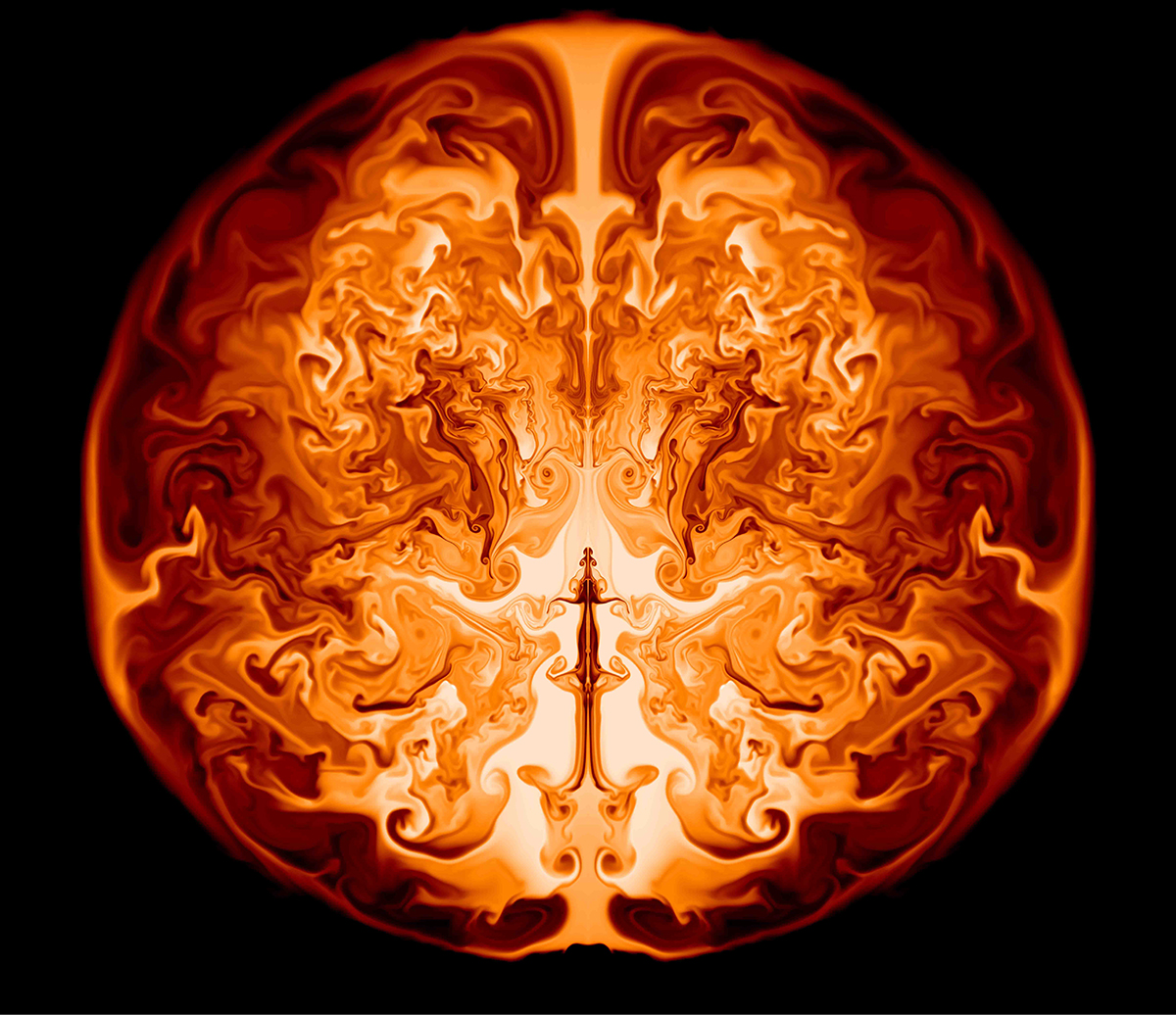

Concentraciones de CO2: altas en rojo y bajas en azul.

_____

Fuente:

http://www.aps.org/publications/apsnews/201505/environmental.cfm